Últimas Noticias

Diarios de Posadas

Deportes Nacionales

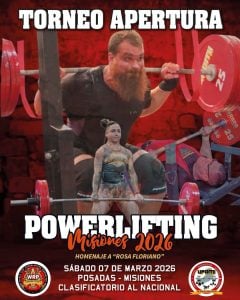

Deportes en Misiones

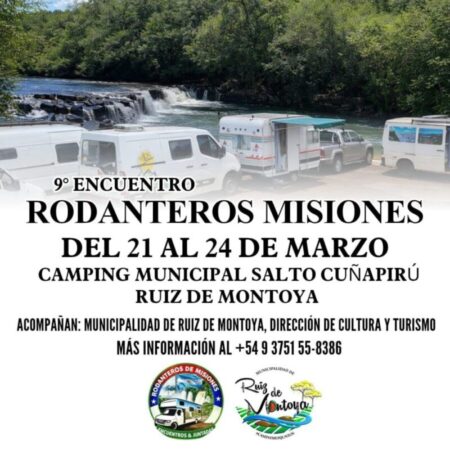

Interior de Mnes

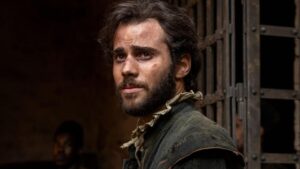

Iguazú (LaVozDeCataratas) En el marco del Día del Bailarín, LaVozDeCataratas dialogó con Lautaro Lambaré, joven artista…

Institucionales

Diarios Nacionales

Diarios Internacionales

Más Noticias

//

//